Et voilà, c’est à nouveau cette époque de l’année : Devoxx France 2025.

Toujours un moment un peu hors du temps, entre retrouvailles, discussions passionnantes, un peu de bière (soyons honnêtes) et beaucoup de bonne humeur.

Mais surtout, c’est chaque année l’occasion de se rappeler à quel point le monde du développement évolue vite — et à quel point c’est inspirant de prendre une pause pour s’en rendre compte.

Voici donc un petit retour sur quelques conférences qui nous ont marqués cette année.

🧭 Sommaire

- ⚡ La réactivité et les signaux : démystifions la magie du frontend

- 🔐 Securing LLM-Powered Applications: Overcoming Security and Privacy Challenges

- 🧠 Sous le capot des LLMs : toutes ces questions que vous n’avez jamais osé poser

- 🤖 Créer des applications intelligentes avec Quarkus et LangChain4j

- 🗓️ LLMs can't optimize schedules, but AI can!

- 💬 RETEX d’une autiste en quête d’inclusion

- 🕵️ Et si on parlait de "malware craftsmanship" ?

- 🎯 45 min pour mettre son application à genoux : le guide complet du test de charge

- 🦄 Dans les coulisses des géants de la Tech !

- 🥊 Bring the Action: Using GraalVM in Production

- 🚀 Accélérer le démarrage des applications Java

- 🧊 Apache Iceberg : pourquoi devez-vous connaitre ce nouveau format de stockage de données ?

- 🎤 Conclusion

⚡ La réactivité et les signaux : démystifions la magie du frontend

Une conférence animée par Estéban Soubiran (Maiaspace), qui nous a plongé dans l’univers de la réactivité — un mot qu’on voit partout en ce moment côté frontend, souvent entouré d’une aura un peu mystique.

Grâce à l’exploration de la bibliothèque Alien Signals, Estéban a réussi à montrer que derrière cette “magie”, se cachent en fait des concepts simples et accessibles.

Et nous, ce qui est simple, on adore (comme disait Boileau : "Ce qui se conçoit bien s’énonce clairement et les mots pour le dire arrivent aisément").

Une présentation hyper dynamique, interactive, avec des votes, des emojis (tellement qu’on ne voyait parfois plus les slides 😄), et une discussion post-conf tout aussi intéressante. Un vrai moment de fraîcheur.

🔐 Securing LLM-Powered Applications: Overcoming Security and Privacy Challenges

Cette session, présentée par Brian Vermeer (Snyk) et Lize Raes (Naboo.ai), abordait un sujet à la fois pointu et d’actualité : comment garder le contrôle quand on intègre des LLM (LangChain4j pour l'exemple) dans une application.

On y a vu des cas concrets de problèmes (injection de prompts, fuites de données sensibles, …), mais aussi des pistes de protections avec des garde-fous bien pensés.

Le tout dans une ambiance détendue, avec beaucoup d’humour — mais un contenu technique solide. Du très haut niveau.

🧠 Sous le capot des LLMs : toutes ces questions que vous n’avez jamais osé poser

Dans ce talk en duo, Guillaume Laforge (Google) et Didier Girard (SFEIR) se proposent de lever le voile qui entoure les LLMs.

On oublie par exemple souvent que les LLMs ne traitent pas les mots par lettre, mais par token. Alors, arrêtez de leur demander combien de lettres comporte un mot 😉

Il existe plusieurs algorithmes de tokenization : BPE, WordPiece, SentencePiece, etc. Certains sont réversibles, d'autres non.

Les LLMs excellent à prédire le token suivant — à tel point qu’un des défis majeurs est justement… de réussir à les arrêter 😄. Tout l’enjeu devient alors de les guider finement dans cette génération.

Nous n’allons pas refaire ici tout le contenu de leur conférence (bientôt dispo sur YouTube), mais en attendant, sachez qu’une ancienne version des slides est déjà disponible !

🤖 Créer des applications intelligentes avec Quarkus et LangChain4j

Zineb Bendhiba (Red Hat) et Clément Escoffier (Red Hat) nous plongent dans l’univers fascinant de l’intégration des LLMs dans les applications grâce à Quarkus et LangChain4j.

Le talk jongle habilement entre théorie et pratique. D’abord, les intervenants montrent à quel point il est simple d’appeler un modèle de langage dans Quarkus : quelques lignes suffisent pour obtenir une réponse structurée sous forme d’objet métier, avec gestion des erreurs incluse.

Ils explorent ensuite l’approche RAG (Retrieval Augmented Generation). Après une introduction claire des concepts, ils enchaînent avec une implémentation dans Quarkus, en y ajoutant des Guardrails pour encadrer la qualité des réponses générées.

Enfin, le duo aborde le Model Context Protocol (MCP) et la capacité à exposer des méthodes Java directement au modèle - lui donnant de nouveaux moyens d’agir, de raisonner et de produire des réponses plus pertinentes.

Un talk riche, clair, et inspirant pour celles et ceux qui veulent embarquer des LLMs dans leurs applications.

🗓️ LLMs can't optimize schedules, but AI can!

Tom Cools (Timefold) et Geoffrey De Smet (Timefold) sont venus parler d’intelligence artificielle — mais sans LLM cette fois-ci.

Leur sujet : l’optimisation de calendriers avec Timefold. Un problème qui semble simple en apparence, mais qui devient rapidement complexe dès qu’on y ajoute des contraintes réelles (équité, préférences, réglementations…). Par exemple : répartir les gardes dans un hôpital. On se rapproche alors du célèbre problème du voyageur de commerce.

Le twist sympa ? Timefold a justement été utilisé pour générer le planning de Devoxx France cette année !

Une très belle démonstration d’un outil puissant, capable de résoudre une multitude de cas concrets si l’on prend le temps d’y réfléchir. Une belle découverte, avec plein d’idées en tête pour l’utiliser à notre tour.

💬 RETEX d’une autiste en quête d’inclusion

Un moment fort du salon : la conférence de Véronique Sermage (Onepoint), "D’officier de l’Armée de Terre à dév : RETEX d’une autiste en quête d’inclusion".

Elle y raconte son parcours personnel, du monde militaire à celui du développement, avec un mélange d’humour, d’émotion et de franchise.

C’est le genre de témoignage qui marque : elle parle sans détour des difficultés, des maladresses qu’on peut tous faire sans le vouloir, mais aussi de ce qu’un environnement inclusif change, pour elle comme pour d’autres.

Une conférence qui fait réfléchir, et qui donne envie de faire mieux, en équipe comme en entreprise.

🕵️ Et si on parlait de "malware craftsmanship" ?

Sonia Seddiki et Nailya Bogrova (Sii Ouest) ont livré une conférence aussi captivante qu’inquiétante sur DEV#POPPER, un malware caché dans un dépôt Git… envoyé à des développeurs sous prétexte d’entretiens techniques !

Tout part d’une simple ligne de JavaScript qui télécharge discrètement du code Python depuis un serveur distant. Le code est offusqué dans des chaînes de caractères ou même dissimulé dans des images, rendant sa détection bien plus difficile.

Au fil de l’analyse, on découvre comment le virus s’articule, exfiltrant les données de l’ordinateur vers un serveur - probablement nord-coréen.

Le talk explore également plusieurs techniques utilisées pour contourner les antivirus, ainsi que des outils d’analyse de malware pour travailler avec ces logiciels malveillants.

Un talk digne d’un thriller numérique 🧑💻🔍 !

🎯 45 min pour mettre son application à genoux : le guide complet du test de charge

Loïc Ortola (Takima) et Mathilde Lorrain (Takima) ont offert une performance de haute volée ! À la fois divertissante et très instructive, le titre du talk ne ment pas : en 45 minutes, ils ont passé leur application Takiciné au crible des tests de performance, et la pauvre n’en est pas ressortie indemne.

Le show commence avec une parodie impressionnante de Bref, qui présente le problème et les concepts essentiels. En quelques minutes, Loïc et Mathilde réussissent à scotcher la salle, qui explose en applaudissements.

Le talk couvre les principes généraux du test de performance, en détaillant la construction d’un parcours de test et l’utilisation des fonctionnalités de Gatling pour rendre ces parcours plus réalistes et aléatoires.

Ils abordent également l’organisation du code et des tests, la visualisation des résultats, ainsi que l’intégration de Gatling dans un pipeline CI, vous permettant de vous lancer en toute confiance pour faire passer vos applications au test de charge.

🦄 Dans les coulisses des géants de la Tech !

Rachel Dubois (Bttrways) a été coach Agile chez Spotify et commence par nous présenter la semaine type d'Anna, une Product Manager chez Spotify. Elle nous parle ainsi des outils techniques et organisationnels mis en place par Spotify pour s'adapter le plus vite possible aux retours, conscients ou non, faits par les utilisateurs. Cette adaptabilité n'est pas sans rappeler celle d'un organisme vivant.

Et c'est à travers cette analogie que Rachel va disséquer une licorne pour nous faire découvrir les systèmes sophistiqués pour observer le marché (système nerveux), prévenir les problèmes (système immunitaire) et assurer la circulation de l'information (système circulatoire) qui permettent aux licornes de s'adapter à leur écosystème.

Très belle conférence qui permet à tous de se rappeler que la vraie agilité, c'est la capacité à s'adapter, et non un framework de réunions. 😉

🎁 Et en bonus, Rachel a eu le bon goût de partager ses slides sur LinkedIn

🥊 Bring the Action: Using GraalVM in Production

Alina Yurenko (Oracle), developer advocate chez Oracle, a commencé par démontrer que migrer de la JVM à GraalVM est étonnamment simple : un plugin Maven suffit pour effectuer cette transition.

Elle a partagé des astuces précieuses pour optimiser le développement avec la compilation native, notamment l'utilisation du paramètre -O0 pour réduire considérablement le temps de compilation; essentiel pour améliorer l'expérience du développeur.

Alina a également abordé les défis liés à l'utilisation de bibliothèques faisant appel à la réflexion, une fonctionnalité non supportée directement en compilation native. Elle a présenté plusieurs outils et techniques pour contourner cette limitation et a fourni cette liste des bibliothèques compatibles nativement.

L'une des optimisations les plus impressionnantes présentées était le Profile Guided Optimization (PGO), qui permet de surpasser les performances de la JVM même après son temps de chauffe (tests à l'appui). Nous avons également pu (re)découvrir les garbage collectors les plus adaptés pour optimiser encore davantage la vitesse d'exécution (en l'occurrence le plus rapide reste G1).

Enfin, Alina a partagé un aperçu des futures évolutions de GraalVM, notamment la possibilité de compiler en WebAssembly et l'introduction des Native Image Layers pour améliorer drastiquement la vitesse de compilation. Ces avancées promettent de rendre GraalVM encore plus performant et polyvalent dans les environnements de production, ce qui n'est pas pour nous déplaire !

🚀 Accélérer le démarrage des applications Java

Optimisez vos applications Spring Boot avec CDS et Project Leyden et Booster le démarrage des applications Java : optimisations JVM et frameworks

Ces deux conférences ont abordé l’optimisation du démarrage des applications Java, et particulièrement avec Spring Boot, avec des approches complémentaires.

Sébastien Deleuze (Broadcom) et Olivier Bourgain (Mirakl) ont présenté le Class Data Sharing (CDS), une technique historique qui réduit le temps de démarrage des applications Java en partageant des métadonnées de classes entre plusieurs exécutions de la JVM. Ils ont ensuite exploré des approches plus récentes, détaillant leurs avantages et inconvénients :

- Spring AOT (Ahead-of-Time Compilation) : génère du code optimisé à la compilation, allégeant la JVM au démarrage pour de meilleures performances

- CRaC (Coordinated Restore at Checkpoint) : sauvegarde l’état d’une application pour un démarrage quasi instantané, directement dans un état chaud

- Native Image (GraalVM) : compile l’application en exécutable natif, offrant des démarrages ultra-rapides et une faible consommation mémoire, mais avec des limites de compatibilité

- Cache AOT (JEP 483) : intégré à JDK 24, étend CDS en préchargeant et liant les classes dans un cache, réduisant significativement le temps de démarrage sans modifier le code

- Project Leyden : lancé avec Java 24, optimise la JVM pour des performances maximales dès le démarrage, en s’appuyant sur CDS avancé et des techniques comme JEP 483

Leurs benchmarks ont illustré les gains de chaque approche.

👉 N’hésitez pas à suivre Project Leyden et les nouveautés de Spring, déjà disponibles avec Java 24 — la future LTS semble prometteuse.

🧊 Apache Iceberg : pourquoi devez-vous connaitre ce nouveau format de stockage de données ?

Dans cette conférence de Bertrand Paquet (Doctolib), Apache Iceberg a été présenté comme une réponse moderne aux limites des formats traditionnels comme CSV ou Parquet dans des contextes analytiques cloud à grande échelle.

Les tests partagés montrent bien les limites du CSV (requêtes lentes, filtres inefficaces, schéma rigide) et les améliorations apportées par Parquet (stockage colonne, compression). Mais même Parquet montre ses limites en cas d’évolution de schéma ou de besoin de mises à jour fréquentes.

C’est là qu’Iceberg entre en jeu : il transforme un simple stockage de fichiers Parquet en un véritable format de table transactionnel avec versioning, opérations INSERT/UPDATE/DELETE, gestion de schéma évolutif, et optimisation poussée des requêtes (via des métadonnées intelligentes). Développé par Netflix et aujourd'hui open sourcé, ce serait LA solution face à Delta Lake ou autre concurrent selon Bertrand.

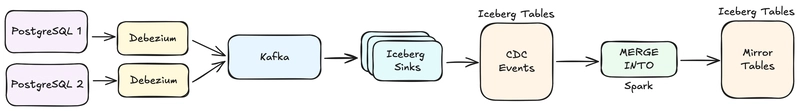

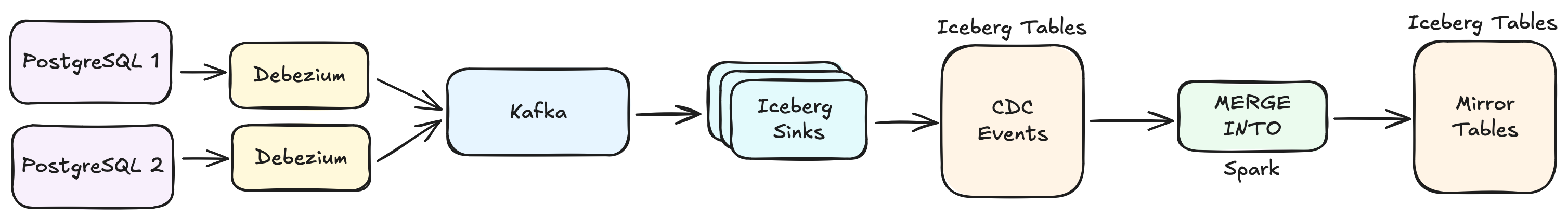

Intégré dans des pipelines type Kafka → Spark → Iceberg, il permet une ingestion quasi temps réel tout en gardant une structure robuste et interrogeable efficacement.

Dataflow Doctolib présenté par Bertrand durant la conférence.

Le message clé : Iceberg n’est pas fait pour du transactionnel pur, mais pour une écriture en micro-batch scalable. Chaque changement devient un snapshot versionné, facilitant le debug (tables Iceberg des events Debezium) et l'analyse quasi temps réel des données de production (tables Iceberg mirror).

Apache Iceberg s’impose comme une solution pertinente à envisager pour structurer efficacement ses données analytiques, en particulier dans des architectures modernes où la flexibilité, la scalabilité et l’évolutivité du schéma sont des enjeux clés.

🎤 Conclusion

Devoxx France 2025, c’était encore une fois un grand cru : trois jours hors du temps pour apprendre, s’inspirer, se questionner… et surtout partager. Nous en repartons avec des idées plein la tête, des envies de tester, de creuser, d’explorer. Ce genre d’événement nous rappelle pourquoi on aime tant ce métier : parce qu’il évolue sans cesse, et parce qu’il se nourrit des autres.

Cette année, pour nous, Devoxx c'est aussi 11 speakers Onepoint présents sur scène ! Une fierté collective immense, et une belle preuve de la dynamique technique que nous portons ensemble.

Être speaker à Devoxx, c’est une aventure à part entière : un public incroyable, du stress bien sûr, et surtout un accompagnement aux petits oignons. Des gilets rouges toujours disponibles, une logistique impeccable, une ambiance bienveillante… Tout est réuni pour qu’on puisse donner le meilleur de nous-mêmes.

🙏 Merci aux organisateurs pour cette machine bien huilée, et merci à toutes les personnes croisées au détour d’un couloir, d’un talk, d'un stand ou d’un apéro — c’est aussi ça, la magie de Devoxx.

On rentre boostés. Et on reviendra !