La Inteligencia Artificial generativa ha traído consigo todo un panorama de posibilidades que está revolucionando las industrias, mejorando procesos, transformando nuestra jornada cotidiana con herramientas que aceleran y agilizan tareas repetitivas, ayudan a mejorar la calidad de nuestros productos y nos han facilitado recursos con los que hace unos meses nos era más difícil contar, como videos e imágenes para nuestros proyectos personales.

Las estadísticas reflejan su incorporación en el mundo de los negocios y cómo se percibe su utilización. Por ejemplo, de acuerdo con el estudio Our life with AI de Google e IPSOS 2024, 9 de cada 10 encuestados piensa que la IA cambiará las industrias y/o los trabajos en los próximos 5 años. Por otra parte, quienes han utilizado esta tecnología, en un 77% consideran que tiene un impacto positivo importante en cómo accedemos a la información, y un 71% de ellos piensan que la IA tiene un impacto positivo en cómo trabajamos. Definitivamente, la IA llegó para quedarse.

Ahora bien, desde mi perspectiva, las herramientas que tenemos disponibles hoy en día habilitan las creaciones de nuestra imaginación, han eliminado gran cantidad de barreras y son económicamente viables.

En el campo de la IA Generativa, desde hace ya algún tiempo AWS consolidó su posición con Amazon Bedrock, el cual es un servicio completamente administrado que facilita enormemente la incorporación de la IA Generativa a nuestros proyectos personales y empresariales.

Bedrock, a través de una API unificada, nos permite de manera sencilla trabajar y experimentar con diversos modelos fundacionales, eliminando barreras de incorporación de esta tecnología a nuestros proyectos.

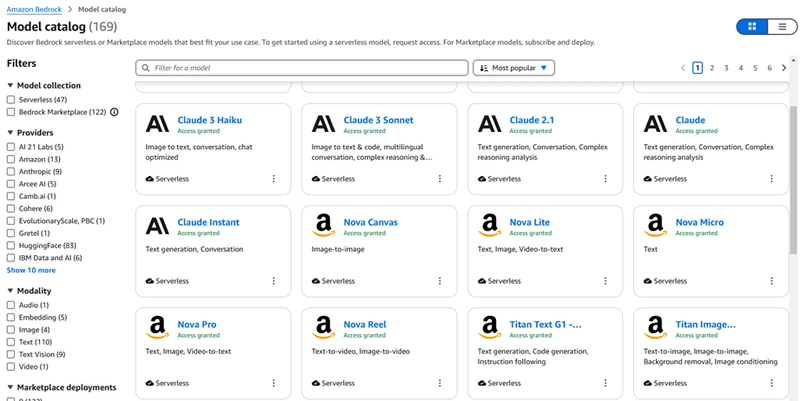

En particular, Bedrock destaca por su flexibilidad: fácilmente nos permite cambiar modelos según las necesidades específicas de cada caso de uso. Originalmente se limitaba a una cantidad de modelos fundacionales, sin embargo, recientemente ha expandido su catálogo, incorporando no solo modelos de los líderes tradicionales del mercado como Anthropic, Amazon, Meta, Mistral AI, entre otros, sino que también ha incluido modelos de proveedores emergentes. Hoy en día contamos con más de 160 opciones disponibles, lo cual proporciona un espectro más amplio para seleccionar el modelo que mejor se adapte a nuestros requisitos particulares.

Quienes han experimentado sabrán que el trabajo con IA Generativa requiere un enfoque personalizado, ya que cada caso de uso puede beneficiarse de diferentes modelos. No se trata de una receta de cocina con ingredientes preestablecidos; cada caso requiere una valoración.

La actual diversidad de opciones presenta múltiples combinaciones de rendimiento y costos, haciendo que la evaluación y selección del modelo más apropiado sea un paso crítico tanto para la calidad del resultado como para la optimización de recursos financieros.

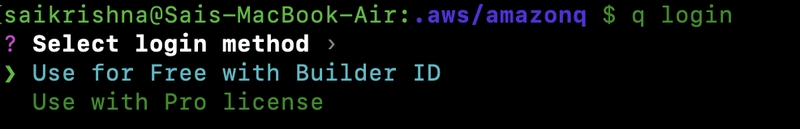

Figura 1. Modelos disponibles en Amazon Bedrock.

Afortunadamente, entre las nuevas funcionalidades disponibles en Amazon Bedrock se encuentra la capacidad de evaluar modelos, lo que nos permite seleccionar de manera más acertada el modelo o los modelos que requerimos para implementar nuestro caso de uso. En particular, considero que la elección de cualquier servicio o solución, en términos generales, debe cumplir primero con satisfacer el requerimiento de negocio. Además, debe hacerlo de forma segura, eficiente y, sin lugar a dudas, de manera costo-efectiva.

Evaluación de Modelos en Amazon Bedrock

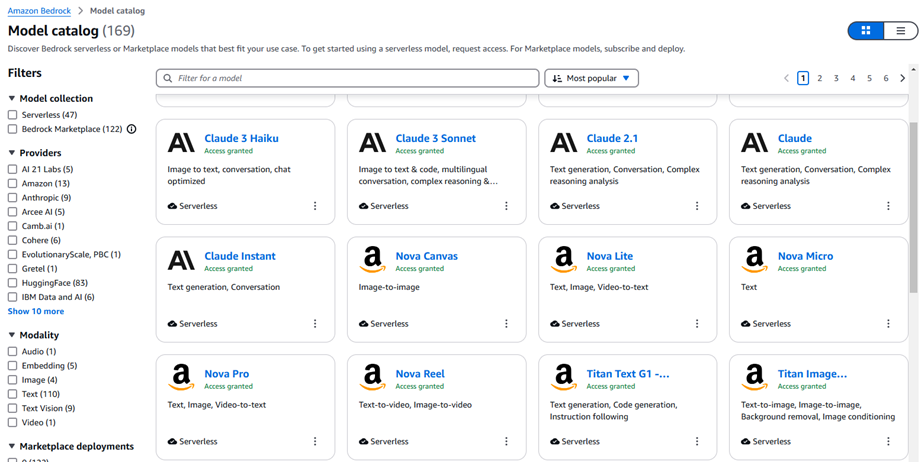

Con esta facilidad es posible evaluar el desempeño de un modelo para tareas específicas. Existen disponibles cuatro tipos de evaluaciones (ver Figura 2), que permiten medir el desempeño del modelo según la tarea.

Figura 2: Métodos disponibles para evaluar modelos en Amazon Bedrock

Evaluaciónes Automáticas

Me enfocaré en las evaluaciones automáticas en este artículo. El propósito de este tipo de evaluación es comparar diferentes modelos o versiones del mismo y evaluar así su desempeño, inclusive pueden ser aplicadas a modelos personalizados. Es importante destacar que estas evaluaciones pueden ser muy valiosas no obstante es recomendable una valoración complementaria.

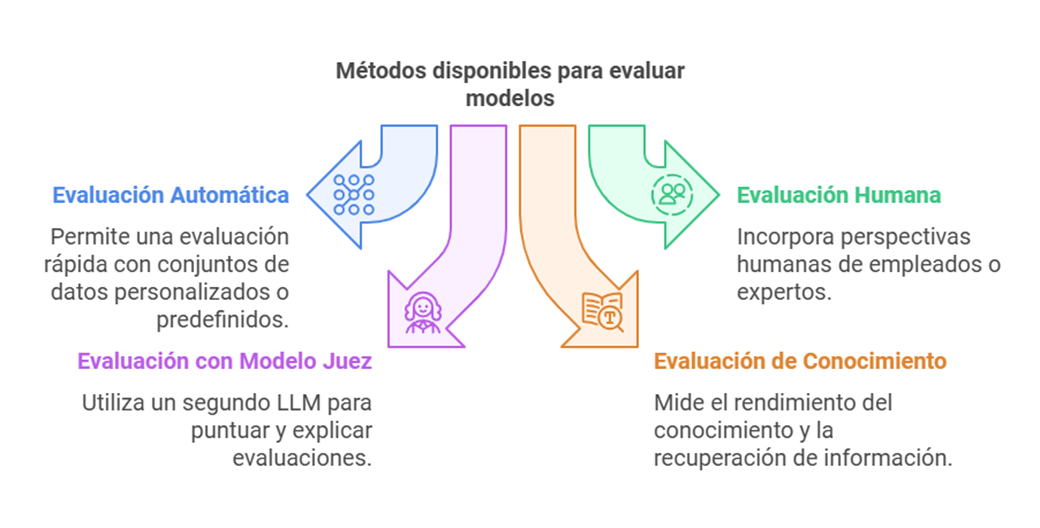

El procedimiento para evaluar un modelo es bastante sencillo. Sin embargo, antes de explicar cómo se lleva a cabo, me enfocaré en el contexto: ¿qué se puede evaluar? y ¿cómo se realiza?. Es posible evaluar diferentes tipos de tareas (ver Figura 3).

Figura 3: Tareas que se pueden evaluar en Amazon Bedrock

Para cada uno de estos ámbitos o tareas, es posible evaluar:

Precisión (Accuracy): Esta métrica mide qué tan bien un modelo realiza una tarea específica, evaluando la proporción de respuestas correctas. Las métricas utilizadas dependen del tipo de tarea.

Robustez: Evalúa la consistencia de las salidas del modelo frente a pequeñas variaciones en la entrada.

Toxicidad: Permite evaluar la presencia de contenido dañino u ofensivo en las respuestas generadas por el modelo.

💡 Nota:

Es importante tener en cuenta que cada modelo a evaluar debe ser analizado uno a la vez.

Evaluando Modelos para Atención de Respuestas a Preguntas (Q&A)

Seleccioné este tipo de tarea para iniciar, ya que está asociado a los casos de uso más comunes entre nuestros clientes. A continuación, los detallo:

Soporte y servicio al cliente: Se emplea para responder preguntas frecuentes, como la consulta de guías, el estado de tiquetes, errores comunes en plataformas, mejores prácticas e incluso el estado de pedidos.

Comercio: Se utiliza para verificar el estado de órdenes de compra, gestionar devoluciones, consultar la disponibilidad de productos, entre otros.

Asistentes legales: Apoyan en consultas jurídicas y automatización de procesos relacionados.

Al evaluar este tipo de tareas, es posible seleccionar una o varias métricas de interés. Además, se pueden utilizar conjuntos de datos personalizados o los proporcionados por defecto, los cuales listaré y ejemplificaré a continuación.

Set de Evaluación

BoolQ

El primer set corresponde a BoolQ. Este conjunto proporciona más de 15,000 preguntas de tipo Sí o No. Las preguntas están basadas en búsquedas reales realizadas por personas y están compuestas por:

- Un contexto

- La pregunta

- La respuesta esperada

Veamos este ejemplo para ilustrar cómo está conformado el dataset.

Al revisar un conjunto como este, no puedo evitar pensar en los exámenes de comprensión lectora que alguna vez nos aplicaron en la escuela:

Contexto:

"La Torre Eiffel fue construida entre 1887 y 1889 para la Exposición Universal de París. Originalmente, la torre estaba planificada para ser demolida después de 20 años, pero se salvó debido a su utilidad como antena de radio."Pregunta:

"¿Estaba planeado que la Torre Eiffel fuera una estructura permanente?"Respuesta esperada:

"No"

Dependiendo del resultado obtenido, podemos saber qué tan bien comprende el contexto nuestro modelo y si llega a una conclusión adecuada y precisa de Sí o No.

Este es el resultado que obtuvo uno de los modelos que analicé:

Es interesante cómo no logra interpretar correctamente todas las preguntas, lo cual evidencia las diferencias de comprensión entre modelos.

| Question | Expected Answer | Model Answer | Result |

|---|---|---|---|

| Is White Castle only on the east coast? | No | No | ✅ |

| Can you go to jail for civil contempt of court? | Yes | Yes | ✅ |

| Can you hit the backboard on a free throw? | Yes | No | ❌ |

| Did England ever win the soccer world cup? | Yes | (No answer) | ❌ |

| Can I send a letter in the mail without a return address? | Yes | No | ❌ |

| Is it illegal to pass on a solid yellow line? | Yes | (No answer) | ❌ |

| Do red yellow and orange peppers taste different? | Yes | (No answer) | ❌ |

| Has Maroon 5 ever performed at the Super Bowl? | Yes | Yes | ✅ |

Natural Questions

Este conjunto de datos está compuesto por preguntas reales enviadas por los usuarios a Google Search. Contiene aproximadamente 300,000 preguntas, y cada una incluye los siguientes elementos:

- Pregunta del usuario: Una consulta en lenguaje natural.

- Artículo de Wikipedia asociado: Documento donde se encuentra la respuesta.

- Respuesta corta: El fragmento exacto del texto que responde directamente a la pregunta.

- Respuesta larga: Un extracto más amplio que proporciona contexto adicional.

Ejemplo:

- Pregunta del usuario: ¿Cuál es la capital de Canadá?

- Artículo de Wikipedia asociado: Canadá

- Respuesta corta: Ottawa

- Respuesta larga: La capital de Canadá es Ottawa. Es la cuarta ciudad más grande del país y se encuentra en la provincia de Ontario. Ottawa es el centro político de Canadá y alberga el Parlamento, la residencia del Primer Ministro y otras instituciones gubernamentales.

Veamos un subconjunto aplicado a los modelos y la respuesta de alguno de ellos.

Natural Questions – Model Evaluation

| Question | Expected Answer | Model Answer | Match |

|---|---|---|---|

| A bond that the issuer has the right to pay off before its maturity date? | callable bonds OR: callable |

Callable bond. | ✔️ |

| Who was Charlie writing to in Perks of Being a Wallflower movie? | an unknown recipient | An unknown recipient. | ✔️ |

| When did Avatar: The Last Airbender first air? | February 2005 OR: February 21, 2005 |

February 21, 2005 | ✔️ |

| Where are the Winter Olympic Games being held this year? | Pyeongchang County, Gangwon Province, South Korea OR: Pyeongchang County, South Korea |

Beijing, China. | ❌ |

| What is the purpose of the Terra satellite? | helps scientists better understand the spread of pollution around the globe OR: to monitor the state of Earth's environment and ongoing changes in its climate system |

Earth observation and monitoring. | ❌ |

| When was the last time Michigan beat Ohio State? | 2011 | 2011 | ✔️ |

| What is the most current Adobe Flash Player version? | 28.0.0.137 | Adobe Flash Player discontinued updates. | ❌ |

| Where did Dr. Seuss write his first book? | returning from an ocean voyage to Europe | La Jolla, California. | ❌ |

TriviaQA

Este último conjunto de datos está compuesto por más de 650,000 preguntas, que incluyen los siguientes elementos:

- Pregunta: El enunciado planteado.

- Respuesta esperada: La respuesta correcta que se busca.

- Documentos de evidencia: Aproximadamente seis documentos por pregunta, que corresponden a artículos, noticias o documentos web que contienen la respuesta.

Ejemplo:

- Pregunta: ¿Quién escribió Hamlet?

- Respuesta esperada: William Shakespeare

- Documentos de evidencia: Páginas de Wikipedia, artículos de noticias o documentos web que contienen la respuesta.

Este es un pequeño subset de datos aplicados a uno de los modelos evaluados.

TriviaQA – Model Evaluation Subset

| ❓ Question | ✅ Expected Answer | 🤖 Model Answer | 🎯 Accuracy | 🛡️ Robustness |

|---|---|---|---|---|

| What is the connection between the computer programming language ada, developed in 1980, and the daughter of poet lord byron? | Charles Babbage's "analytical engine" | Ada was named after Ada Lovelace... working with Babbage's Analytical Engine. | 0.211 | 30.9 |

| How many points is a 'try' worth in a game of rugby union? | five / 5 | 5 | 1.0 | 0 |

| What year: barry white was born, so was sylvester stallone, and so was roger daltrey out of the who? | 1944 | None of them were born in the same year... | 0.105 | 100 |

| At 'minus twenty three feet', in which country is the lowest point in the eu? | Netherlands | Netherlands | 1.0 | 0 |

| Point barrow is the most northerly point of which country? | United States of America | United States | 1.0 | 0 |

| What is the address of the british prime minister? | 10 Downing Street | 10 Downing Street, London, SW1A 2AA, United Kingdom | 0.545 | 7.5 |

| "doo lang doo land doo lang" is the start of which hit from the 1960s? | He's So Fine | Blue Moon | 0.0 | 0 |

| Where is the homeland of queen boudica, who led a revolt against the romans in england in the first century ce? | East Anglia, England | Norfolk, England (territory of the Iceni tribe) | 0.222 | 62.2 |

| Derived from latin for 'place', what anglicized french word commonly means 'instead' in formal communications? | lieu | lieu | 1.0 | 0 |

| His debut album 'disc-overy' was released in 2010. by what stage-name is patrick chukwuemeka okogwu better known? | Tinie Tempah | Tinie Tempah | 1.0 | 0 |

En la próxima entrega, analizaremos los resultados obtenidos a partir de la evaluación de cada modelo